In vielen Projekten wird der Raspberry Pi als Überwachungskamera oder für Machine Learning Aufgaben verwendet. Hierbei ist oft Text auf Bildern zu sehen, welcher für die Anwendung interessant ist. Diesen möchten wir extrahieren und so umwandeln, dass wir den Text mit einem Programm analysieren können. Diese Art von Texterkennung ist auch mit dem Raspberry Pi möglich und dabei nicht einmal schwierig. Entweder lesen wir Text aus statischen Bildern aus oder einen Kamera-Livestream.

In diesem Tutorial schauen wir uns daher an, wie wir mit dem Raspberry Pi Texterkennung realisieren können und was wir dafür brauchen.

Benötigte Komponenten zum Starten

Der Hauptteil der Anwendung ist rein Software-basierend. Daher brauchen wir nur wenig Hardware, um die Texterkennung einzurichten. Folgende Komponenten werden wir im Folgenden benötigen und nutzen.

- Leistungsstarken Raspberry Pi (bspw. Model 4)

- Offizielle Raspberry Pi Kamera

- alternativ: USB Webcam

- Stromanschluss: Micro-USB-Kabel und USB Adapter

Bildschirm, Tastatur und Maus können zwar genutzt werden, aber da wir remote auf dem Raspberry Pi arbeiten, brauchen wir sie nicht unbedingt.

Daher solltest du deinen Raspberry Pi entsprechend eingerichtet haben, sowie SSH aktiviert haben und ebenfalls eine Remotedesktopverbindung aufgebaut haben. Danach können wir direkt starten.

Was ist Texterkennung (OCR) und wie funktioniert es auf dem Raspberry Pi?

Kurz gesagt ist eine Texterkennung (optical character recognition, Abkürzung OCR) auf Bildern eher eine Erkennung einzelner Buchstaben. Sind diese nah genug beieinander, ergeben sie ein Wort.

In vorherigen Tutorials haben wir gesehen, dass wir ein Modell trainieren können, welches Objekte auf Bildern erkennt. Falls wir nun alle (lateinischen) Buchstaben – statt Objekte – trainieren, so könnten wir diese mittels unseres Models auch wieder erkennen.

In der Theorie funktioniert das, allerdings ist es mit sehr viel Aufwand verbunden. Verschiedene Schriftarten, Farben, Formatierungen, usw. müssten zunächst trainiert werden. Die benötigte Zeit dafür wollen wir uns allerdings sparen.

Daher nutzen wir die Bibliothek Tesseract von Google. Diese beinhaltet bereits solche Modelle und wurde von vielen Entwicklern optimiert.

Installation der Tesseract OCR Bibliothek

Wir können Tesseract entweder selber kompilieren, oder einfach über den Paketmanager installieren. Letzteres geht einfach über folgenden Befehl:

sudo apt install tesseract-ocr

Ob die Installation geklappt hat, können wir ganz einfach mit tesseract -v prüfen.

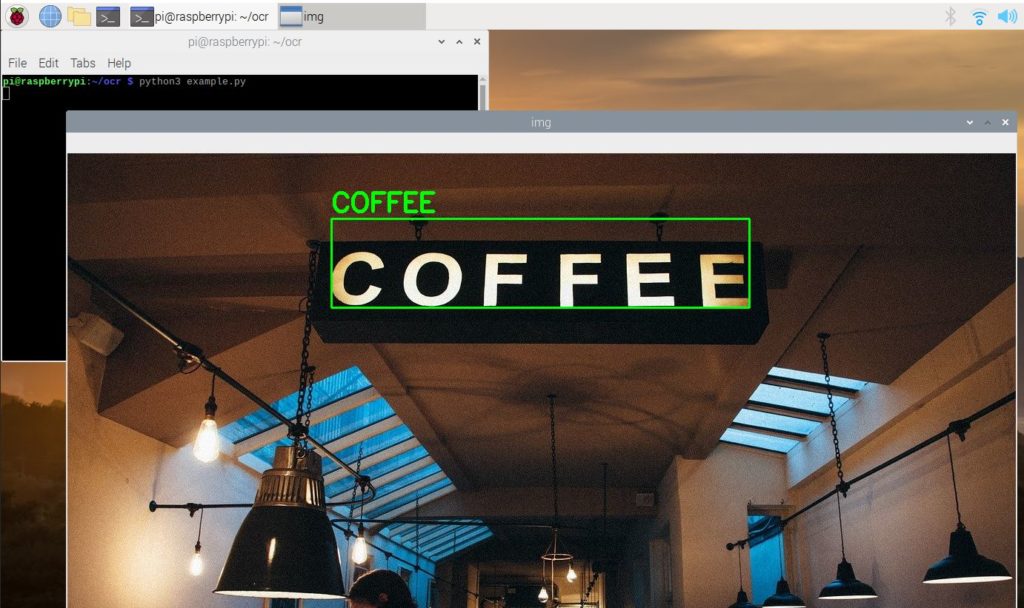

Nun können wir bereits einen ersten kleinen Test machen. Dazu verwenden wir dieses Bild:

Du kannst es hiermit herunterladen:

wget https://tutorials-raspberrypi.de/wp-content/uploads/coffee-ocr.jpg

Anschließend führen wir folgenden Befehl aus:

tesseract coffee-ocr.jpg stdout

Die Ausgabe sieht folgendermaßen aus:

Warning: Invalid resolution 0 dpi. Using 70 instead. Estimating resolution as 554 COFFEE

In unserem Eingabebild wurde also der Text „COFFEE“ erkannt.

Da wir gleich das Ganze in einem Pythonskript nutzen wollen, brauchen wir noch ein paar Bibliotheken, wie OpenCV und einen Python-Wrapper für Tesseract. Diesen installieren wir über den Python-Paketmanager:

pip3 install opencv-python pillow pytesseract imutils numpy

Texterkennung am Raspberry Pi testen – per Pythonskript

Bisher haben wir versucht Wörter nur auf dem unbearbeiteten, farbigen Bild zu erkennen. Oftmals können Vorverarbeitungsschritte das Ergebnis verbessern. Zum Beispiel, indem wir das Farbbild in ein Grauwert-Bild umwandeln. Andererseits können wir auch versuchen Kanten innerhalb eines Bildes zu erkennen, um so Buchstaben/Worte besser hervorzuheben.

Fangen wir also damit an am Raspberry Pi Texterkennung mittels eines Python-Skripts zu ermöglichen. Dazu legen wir einen Ordner und eine Datei an.

mkdir ocr cd ocr sudo nano example.py

Wir fügen folgenden Inhalt ein:

|

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 45 46 47 48 |

import cv2 import pytesseract import numpy as np from pytesseract import Output img_source = cv2.imread('images/coffee.jpg') def get_grayscale(image): return cv2.cvtColor(image, cv2.COLOR_BGR2GRAY) def thresholding(image): return cv2.threshold(image, 0, 255, cv2.THRESH_BINARY + cv2.THRESH_OTSU)[1] def opening(image): kernel = np.ones((5, 5), np.uint8) return cv2.morphologyEx(image, cv2.MORPH_OPEN, kernel) def canny(image): return cv2.Canny(image, 100, 200) gray = get_grayscale(img_source) thresh = thresholding(gray) opening = opening(gray) canny = canny(gray) for img in [img_source, gray, thresh, opening, canny]: d = pytesseract.image_to_data(img, output_type=Output.DICT) n_boxes = len(d['text']) # back to RGB if len(img.shape) == 2: img = cv2.cvtColor(img, cv2.COLOR_GRAY2RGB) for i in range(n_boxes): if int(d['conf'][i]) > 60: (text, x, y, w, h) = (d['text'][i], d['left'][i], d['top'][i], d['width'][i], d['height'][i]) # don't show empty text if text and text.strip() != "": img = cv2.rectangle(img, (x, y), (x + w, y + h), (0, 255, 0), 2) img = cv2.putText(img, text, (x, y - 10), cv2.FONT_HERSHEY_SIMPLEX, 1.2, (0, 255, 0), 3) cv2.imshow('img', img) cv2.waitKey(0) |

Schauen wir uns die einzelnen, interessanten Zeilen an:

- Import der Bibliotheken (Zeile 1-4)

- Laden des Bildes (Zeile 5), Pfad ggf. anpassen!

- Preprocessing-Funktionen, zum Umwandeln in Grauwerte (Zeile 9-23)

- Zeile 32: Hier extrahieren wir jegliche Daten (Text, Koordinaten, Score, etc.)

- Damit wir die Boxen im Anschluss einfärben können, wandeln wir das Graustufenbild ggf. wieder in ein Bild mit Farbkanälen um (Zeile 36-37)

- Ab Zeile 39 werden die Boxen, welche einen Score über 60 haben, eingefärbt.

- Dazu extrahieren wir Text, Start-Koordinaten und Maße der Box in Zeile 41.

- Nur falls ein (nicht-leerer) Text erkannt wurde, zeichnen wir die Box (43-45).

- Anschließend führen wir das Skript aus und warten auf das Drücken der Escape-Taste (Zeile 47/48).

Wir führen das Skript nun aus:

python3 example.py

Anschließend erscheinen die 5 verschiedenen Bilder hintereinander (ESC drücken, damit das nächste Bild erscheint). Der erkannte Text ist darauf markiert. Somit kannst du feststellen, welcher Preprocessing Schritt am besten für dich geeignet ist.

Text im Live-Bildern per Raspberry Pi Kamera erkennen

Bisher haben wir nur statische Bilder als Eingabe für unsere Texterkennung verwendet. Nun möchten wir im Livestream der angeschlossenen Kamera ebenfalls Texte erkennen. Dazu braucht es nur ein paar kleine Veränderungen an unserem vorherigen Skript. Wir erstellen eine neue Datei:

sudo nano ocr_camera.py

Die Datei bekommt folgenden Inhalt:

|

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 |

import cv2 import pytesseract from pytesseract import Output cap = cv2.VideoCapture(0) cap.set(cv2.CAP_PROP_BUFFERSIZE, 1) while True: # Capture frame-by-frame ret, frame = cap.read() d = pytesseract.image_to_data(frame, output_type=Output.DICT) n_boxes = len(d['text']) for i in range(n_boxes): if int(d['conf'][i]) > 60: (text, x, y, w, h) = (d['text'][i], d['left'][i], d['top'][i], d['width'][i], d['height'][i]) # don't show empty text if text and text.strip() != "": frame = cv2.rectangle(frame, (x, y), (x + w, y + h), (0, 255, 0), 2) frame = cv2.putText(frame, text, (x, y - 10), cv2.FONT_HERSHEY_SIMPLEX, 1.0, (0, 0, 255), 3) # Display the resulting frame cv2.imshow('frame', frame) if cv2.waitKey(1) & 0xFF == ord('q'): break # When everything done, release the capture cap.release() cv2.destroyAllWindows() |

Was wir nun geändert haben:

- In Zeile 5/6 definieren wir die Kamera, anstelle eines fixen Bildes. Die Kamera muss angeschlossen und erkannt worden sein.

- In Zeile 10 lesen wir dann den aktuellen Frame aus.

- Wir haben hier auf Vorverarbeitungsschritte verzichtet, aber diese können ganz einfach ebenfalls eingefügt werden (in Zeile 11).

Zu guter Letzt lassen wir das Skript ebenfalls laufen:

python3 ocr_camera.py

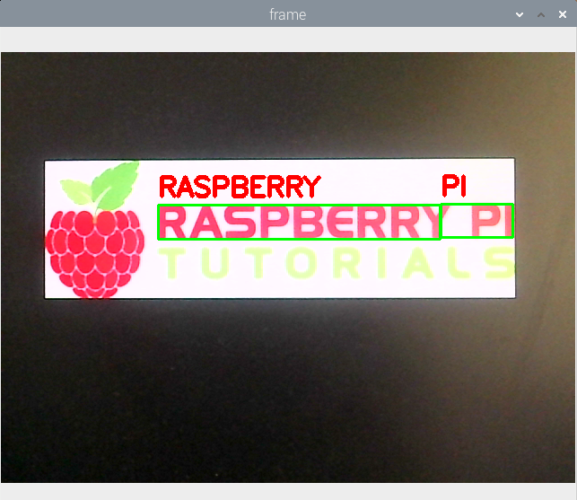

Halte die Kamera nun über einen Text und siehe zu, wie die Worte darauf erkannt werden:

In meinem Beispiel sieht man gut, dass eine Umwandlung in ein Grauwert-Bild Sinn ergeben hätte, da das Wort „Tutorials“ zu hell ist.

Texterkennung in weiteren Sprachen

Tesseract hat standardmäßig nur Englisch als Sprache installiert. Dies können wir hiermit prüfen:

tesseract --list-langs

Wenn du weitere Sprachen, in denen Texte erkannt werden sollen, hinzufügen möchtest, geht das folgendermaßen:

sudo apt-get install tesseract-ocr-[lang]

Ersetze [lang] mit dem Kürzel der Sprache (all installiert alle vorhandenen).

Anschließend kannst du im Python Skript die Sprache auswählen. Füge dazu den Parameter hinzu:

|

1 |

d = pytesseract.image_to_data(img, lang='eng') |

Fazit

Mit Tesseract haben wir ein starkes Tool, welches Out-of-the-Box eine Texterkennung für Bilder oder Frames mitbringt. Dadurch müssen wir kein eigenes Machine Learning Model trainieren und erstellen. Trotz verhältnismäßig hohem Rechenaufwand, funktioniert die Raspberry Pi Texterkennung sehr gut. Mit verschiedenen Bearbeitungsschritten kann das Ergebnis verbessert werden.

Beide Skripte findest du übrigens auch im Github-Repository.

13 Kommentare

Wäre super um eine Nummerschild erkennung zu verwirklichen.

Als automatischer Tor Öffner für Parkplätze oder Campingplätze

Ich habe

pi@raspi41:~ $ tesseract coffee.jpg stdout

viele Male, mit verschiedenen Optionen probiert (den Dateinamen hatte ich auf coffee.jpg gekürzt)

Resultat :

viele Tests später dann, mit

pi@raspi41:~ $ tesseract coffee.jpg stdout –dpi 600

Resultat : COFFEE

hatte ich den gewünschten Erfolg

Rechner : RASPI 4 mit 4 GB und Raspberry PI OS 32 bit

Erkennt das Programm auch Zahlen ?

Oder nur Buchstaben?

Danke für den Tipp!! Nur so gab es ein Resultat…

Cool, werde ich unbedingt die Tage ausprobieren müssen!

Danke für ein wieder mal gut erklärters TUT!

Gruß Ingo

Hallo,

während der Installation von:

pip3 install opencv-python pillow pytesseract imutils numpy

kommt der Fehler:

import skbuild

ImportError: No module named ’skbuild‘

Complete output from command python setup.py egg_info:

Traceback (most recent call last):

File „“, line 17, in

File „/tmp/pip-build-6nbgnufl/opencv-python/setup.py“, line 10, in

import skbuild

ImportError: No module named ’skbuild‘

Was mache ich falsch?

Gruß Ingo

Führe mal in der Konsole „sudo pip3 install skbuild“ wahrscheinlich fehlt dem Buildscript die Bibliothek „skbuild“. Du musst ggf. in dem Befehl für die Konsole (siehe Anfang des Kommentares) Piper wählen, wenn du python 2.7 benutzt.

Sorry für die vielen Fehler… Ich meinte am Endedes Kommentares pip, und am Anfang fehlt noch ein ausführen🙃

Hallo, sieht an sich alles sehr nett aus 🙂

Allerdings tritt bei mir das Problem auf, dass die Zeile

„tesseract coffee-ocr.jpg stdout“

leider gar nichts liefert. Das Ausgabefeld bleibt also einfach leer.

Hoffe mir kann jemand helfen, Grüße

(Ps: Auch „stdout-dpi600“ hat nicht geholfen)

Bei mir hat es mit einem anderen Bild geklappt.

Habe einfach ein Hallo in größere Schriftgröße als jpeg abgespeichert und mit:

tesseract hallo.jpg stdout

die gewünschte Ausgabe bekommen.

Leider bekomme ich das opencv-python immer noch nicht installiert.

Gruß Ingo

genauer muss der befehl für eine erfolgreiche kaffeeerkennung mit dem beispielbild lauten:

tesseract coffee-ocr.jpg stdout --dpi 600mit zwei mal dash (das kommentarscript scheint hier was wegzusnippen):

tesseract coffee-ocr.jpg stdout (minus)(minus)dpi 600

hallo,

leider ergeben die Skripte den Fehler:

ModuleNotFoundError: No module named ‚cv2‘. Muss man das extra installieren? Der Autor hat es anscheinend nicht gemacht…